30. Juli 2024 • Lesedauer 12 Minuten

AI Act tritt in Kraft – Das sind die zentralen Regelungspunkte

Lesen Sie unser Update zum EU AI Act hier (Stand März 2025).

***

Am 2. August 2024 tritt der EU AI Act (zu Deutsch: „KI-Verordnung“) – das weltweit erste Gesetz zur Regulierung künstlich intelligenter Systeme – in Kraft.

KI-System

Zentrale Begrifflichkeit der KI-Verordnung ist das „KI-System”. Dessen Definition orientiert sich eng an der KI-Definition der Organisation for Cooperation and Development (OECD) und beschreibt ein KI-System als ein

„maschinengestütztes System, das für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt ist und das nach seiner Betriebsaufnahme anpassungsfähig sein kann und das aus den erhaltenen Eingaben für explizite oder implizite Ziele ableitet, wie Ausgaben wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können“.

Hieraus leiten sich die folgenden vier Kernelemente ab, mit denen sich ein System als KI-System in Sinne der KI-Verordnung qualifiziert:

- Es handelt sich um ein maschinengestütztes System,

- dieses ist für einen – in unterschiedlichem Maße – autonomen Betrieb ausgelegt,

- Anpassungsfähigkeit nach Betriebsaufnahme, sowie

- die Fähigkeit, aus erhaltenem Input einen Output (wie etwa Vorhersagen, Empfehlungen und Entscheidungen) zu generieren.

KI-Systeme, die bereits unter Harmonisierungsrechtsvorschriften der Europäischen Union fallen, sowie KI-Systeme, die ausschließlich für militärische, verteidigungspolitische oder nationale Sicherheitszwecke verwendet werden, sind vom Anwendungsbereich der KI-Verordnung ausgenommen. Gleiches gilt für KI-Systeme, welche ausschließlich zur wissenschaftlichen Forschung, Entwicklung oder für den rein privaten, persönlichen Gebrauch bestimmt sind.

KI-Systeme, die freie und quelloffene Software (Open-Source-Software) verwenden, unterliegen den Vorschriften der KI-Verordnung grundsätzlich nicht, es sei denn:

- Sie werden als sog. Hochrisiko-KI-Systeme/ Verbotene KI-Systeme auf den Markt gebracht oder in Betrieb genommen; oder

- sie unterliegen als KI-Systeme mit allgemeinem Verwendungszweck besonderen Transparenzverpflichtungen.

Von den genannten Transparenzverpflichtungen sind KI-Systeme mit freier oder quellcodeoffener Software wiederum dann befreit, soweit ihre Parameter, einschließlich Gewichtung, Informationen zur Modellarchitektur und Modellnutzung, öffentlich zugänglich gemacht wurden. Eine Rückausnahme besteht für KI-Systeme mit allgemeinem Verwendungszweck und sog. systemischem Risiko – solche unterfallen ausnahmslos dem Anwendungsbereich der KI-Verordnung, auch wenn diese freie oder quellcodeoffene Software verwenden oder auf solcher basieren.

Risikoklassifizierung

Die KI-Verordnung folgt einem risikobasierten Ansatz. Je höher das mit einem KI-System verbundene Risiko, desto strengere Anforderungen gelten. Dabei unterscheidet die KI-Verordnung zwischen KI-Systemen mit begrenztem, hohem und solchen mit inakzeptablem Risiko. Risiko meint im Kontext der Verordnung „die Kombination aus der Wahrscheinlichkeit des Auftretens eines Schadens und der Schwere dieses Schadens“. Hierauf basierend sind folgende Risikokategorien zu unterscheiden:

Verbotene KI-Praktiken

Unter den Bereich der verbotenen KI-Praktiken (gemeint sind jene KI-Systeme mit inakzeptablem Risiko) fallen etwa das Inverkehrbringen, die Inbetriebnahme sowie die Verwendung von KI-Systemen:

- zur unterschwelligen Beeinflussung des individuellen Verhaltens einer oder mehrerer Personen,

- zur stichprobenartigen Erfassung von Gesichtserkennungsdaten aus dem Internet oder durch Auswertung von Videoüberwachungsaufnahmen,

- zur Ableitung und Erkennung von Emotionen natürlicher Personen am Arbeitsplatz und im Bildungswesen,

- zur Bewertung und Einstufung einzelner oder mehrerer Personen hinsichtlich ihres sozialen Verhaltens (sog. „Social-Scoring“) sowie

- zur biometrischen Kategorisierung, etwa im Hinblick auf die sexuelle Orientierung oder die religiöse Überzeugung einer Person.

Derartige KI-Systeme sind nach der KI-Verordnung verboten.

Hochrisiko-KI-Systeme

Hochrisiko-KI-Systeme sind – im Gegensatz zu den verbotenen KI-Praktiken – nach der KI-Verordnung grundsätzlich erlaubt, unterliegen jedoch strengen Anforderungen und bilden damit das „Herzstück“ der KI-Verordnung. Zu den sog. „Hochrisiko-KI-Systemen“ zählen beispielsweise:

- KI-Systeme, die als Sicherheitskomponente eines Produkts verwendet werden sollen,

- KI-Systeme, die unter die in Anhang II der KI-Verordnung aufgeführten harmonisierten Rechtsvorschriften fallen,

- (ausgewählte) KI-Systeme, die im Bildungssektor, bei Einstellungs- und Beschäftigungsprozessen oder zur Prüfung der Kreditwürdigkeit eingesetzt werden, ausgenommen KI-Systeme zur Aufdeckung von Finanzbetrug, oder

- KI-Systeme, die für sonstige in Anhang III der KI-Verordnung aufgeführte Zwecke eingesetzt werden.

Dabei bleibt die Klassifizierung als Hochrisiko-KI-System aufgrund der Möglichkeit der Kommission, den Katalog in Anhang III der KI-Verordnung durch delegierte Rechtsakte anzupassen, zukunftsoffen und flexibel. Auch steht es einem Anbieter eines Hochrisiko-KI-Systems frei, durch hinreichende Dokumentation zu belegen, dass das KI-System aufgrund spezifischer Besonderheiten kein hohes Risiko in Bezug auf die Gesundheit, Sicherheit oder Grundrechte natürlicher Personen generiert.

Anbieter von Hochrisiko-Systemen sind verpflichtet, ein Risikomanagementsystem einzurichten, umzusetzen, zu dokumentieren und aufrechtzuerhalten, um Risiken zu ermitteln und Maßnahmen zur Risikominderung während des gesamten Lebenszyklus des KI-Systems zu ergreifen; ferner müssen Anbieter solcher Systeme diese vor Inverkehrbringen unter realen Bedingungen („real world conditions“) getestet haben, um optimale Maßnahmen für ein geeignetes Risikomanagement zu identifizieren. Durch das Testen soll sichergestellt werden, dass das KI-System stets im Einklang mit seiner Zweckbestimmung agiert. Hochrisiko-KI-Systeme, in denen Techniken eingesetzt werden, bei denen KI-Modelle mit Daten trainiert werden, müssen mit Trainings-, Validierungs- und Testdatensätzen entwickelt werden, die den in der KI-Verordnung aufgeführten Daten-Governance- und Datenverwaltungsverfahren entsprechen. Die Einhaltung der für Hochrisiko-KI-Systeme geltenden Anforderungen ist mittels geeigneter technischer Dokumentation nachzuweisen, die vor Inverkehrbringen oder Inbetriebnahme des KI-Systems durch den Anbieter zu erstellen und fortlaufend aktuell zu halten ist. Die technische Dokumentation erfolgt im Rahmen einer Selbstbeurteilung durch den jeweiligen Anbieter des KI-Systems. Korrespondierend hierzu treffen den Anbieter während der gesamten Lebensdauer des KI-Systems diverse Aufzeichnungspflichten („Protokollierung“).

Schließlich haben Anbieter von Hochrisiko-KI-Systemen ein Konformitätsbewertungsverfahren durchzuführen. Dessen wesentliches Ziel besteht darin nachzuweisen, dass das in Verkehr zu bringende KI-System den Anforderungen der KI-Verordnung entspricht. Nach erfolgreicher Konformitätsbewertung (mittels interner Kontrolle oder unter Beteiligung notifizierten Stellen) ist das Hochrisiko-KI-System in die durch die Kommission einzurichtende EU-Datenbank einzutragen. Die Eintragung dient maßgeblich der Herstellung von Transparenz gegenüber der Öffentlichkeit. Um die Konformität des KI-Systems mit den Anforderungen der KI-Verordnung nach außen kenntlich zu machen, hat der Anbieter auf dem System sodann eine CE-Kennzeichnung anzubringen. Auch müssen Hochrisiko-KI-Systeme u.a. so konzipiert und entwickelt sein, dass ihr Betrieb hinreichend transparent ist und sie während der Dauer ihrer Verwendung von natürlichen Personen wirksam beaufsichtigt werden können.

KI-Modelle mit allgemeinem Verwendungszweck (GPAI)

Neben den Vorschriften für die vorgenannten Risikokategorien hält die KI-Verordnung spezifische Vorschriften für KI-Modelle mit allgemeinem Verwendungszweck (Englisch: „General-Purpose-AI“, kurz „GPAI“) bereit. GPAI-Modelle charakterisieren sich dadurch, dass sie „eine erhebliche allgemeine Verwendbarkeit aufweisen und in der Lage sind, ein breites Spektrum unterschiedlicher Aufgaben kompetent zu erfüllen und in eine Vielzahl nachgelagerter Systeme oder Anwendungen integriert werden können.“ Dabei differenziert die KI-Verordnung zwischen GPAI ohne und GPAI mit systemischem Risiko, wobei Letztere – entsprechend dem risikobasierten Ansatz der KI-Verordnung – strengeren Anforderungen unterliegt. GPAI-Modelle mit systemischem Risiko (d.h. Risiken mit nachteiligen Auswirkungen auf die öffentliche Gesundheit, die öffentliche Sicherheit, die Grundrechte oder die Gesellschaft als Ganzes) liegen vor, wenn sie entweder von der EU-Kommission als solche eingestuft wurden oder wenn die kumulative Rechenleistung, die für ihr Training benötigt wird, gemessen in Gleitkommaoperationen (FLOPs), mehr als 10^25 beträgt.

Anbieter von GPAI-Modellen, welche sich nach der Berechnung als solche mit systemischem Risiko qualifizieren, unterliegen besonderen Meldepflichten an die EU-Kommission. Außerdem müssen die Anbieter von GPAI-Modellen:

- eine technische Dokumentation des Modells, einschließlich des dieses betreffenden Trainings- und Testverfahrens und der Testergebnisse erstellen, fortlaufend aktualisieren sowie Anbietern, die beabsichtigen, das GPAI-Modell in ihre Systeme zu integrieren, alle hierzu erforderlichen Informationen und Unterlagen zur Verfügung stellen. Die technische Dokumentation hat unter anderem auch zu den Modalitäten der Entwicklung des KI-Systems, zu den Aufgaben, die das Modell erfüllen soll und zum erwarteten Energieverbrauch sowie – im Falle von GPAI-Modellen, die ein potenziell systemisches Risiko bergen – zu den angewandten Bewertungsstrategien und durchgeführten Gegentests (z. B. Red Teaming) auszuführen.

- eine Strategie zur Einhaltung geltender urheberrechtlicher Bestimmungen auf Unionsebene entwickeln und eine hinreichend detaillierte Zusammenfassung der für das Training des GPAI-Modells verwendeten Inhalte nach Maßgabe des von der Europäischen Kommission eingerichteten Büros für Künstliche Intelligenz (auch „AI Office”) bereitgestellten Vorlage erstellen und öffentlich zugänglich machen, sowie

- im Falle von GPAI-Modellen mit systemischem Risiko i) zusätzlich eine Modellbewertung durchführen, ii) mögliche systemische Risiken auf Unionsebene bewerten und mindern, iii) relevante Informationen über schwerwiegende Vorfälle und mögliche Abhilfemaßnahmen verfolgen, dokumentieren und melden sowie iv) geltende Anforderungen an die Cybersicherheit gewährleisten.

Besondere Transparenzpflichten für Anbieter und Betreiber bestimmter KI-Systeme

Für Anbieter und Betreiber bestimmter KI-Systeme gelten – unabhängig von der Höhe des jeweiligen Risikos – Mindestanforderungen. KI-Systeme mit begrenztem Risiko unterliegen demnach zumindest Transparenzverpflichtungen. So sind Anbieter und Betreiber von KI-Systemen, wenn sie für die direkte Interaktion mit natürlichen Personen bestimmt sind (bspw. einfache Chatbots), verpflichtet, ihr Gegenüber darüber zu informieren, dass diese mit einem KI-System interagieren. Anbieter von KI-Systemen, einschließlich KI-Systemen mit allgemeinem Verwendungszweck, die synthetische Audio-, Bild-, Video- oder Textinhalte erzeugen, haben sicherzustellen, dass die Ausgaben des KI-Systems in einem maschinenlesbaren Format gekennzeichnet und als künstlich erzeugt oder manipuliert erkennbar sind.

Regulierungsadressaten

Die KI-Verordnung betrifft:

- Anbieter, die in der Union KI-Systeme in Verkehr bringen oder in Betrieb nehmen oder KI-Modelle mit allgemeinem Verwendungszweck in Verkehr bringen, unabhängig davon, ob diese Anbieter in der Union oder in einem Drittland niedergelassen sind,

- Betreiber von KI-Systemen, die ihren Sitz in der Union haben oder sich in der Union befinden,

- Anbieter und Betreiber von KI-Systemen, die ihren Sitz in einem Drittland haben oder sich in einem Drittland befinden, wenn die vom KI-System hervorgebrachte Ausgabe in der Union verwendet wird,

- Einführer und Händler von KI-Systemen,

- Produkthersteller, die KI-Systeme zusammen mit ihrem Produkt unter ihrem eigenen Namen oder ihrer Handelsmarke in Verkehr bringen oder in Betrieb nehmen,

- Bevollmächtigte von Anbietern, die nicht in der Union niedergelassen sind, sowie

- betroffene Personen, die sich in der Union befinden.

Die zur Identifizierung der konkret einzuhaltenden Anforderungen essentielle Frage, welcher Akteur im Zusammenhang mit welchem KI-System welche Adressatenrolle einnimmt, ist anhand des Definitionenkataloges in Verbindung mit den weiteren Regelungen der KI-Verordnung zu beantworten und fällt im Einzelfall nicht immer leicht. Insbesondere ist nicht ausgeschlossen, dass Akteure Voraussetzungen verschiedener Rollendefinitionen gleichzeitig erfüllen und eine bereits eingenommene Rolle mitunter fließend wechseln, so dass ggf. gesteigerte Anforderungen gelten. Besondere Vorsicht ist in diesem Zusammenhang im Konzernverbund geboten, z.B. wenn ein Konzernunternehmen ein KI-System zunächst nur für sich beschafft, entwickelt oder nutzt, sodann aber auch andere Konzernunternehmen Interesse an dem KI-System finden. Bei Prüfung der jeweiligen Anforderungen und Rollen sind wir gerne behilflich, zumal in diesem Zusammenhang auch Prioritätenregelungen und Anforderungen, die die KI-Verordnung entlang der Wertschöpfungskette statuiert, zu berücksichtigen sind.

KI-Governance

Die Aufgabe über die Einhaltung der KI-Verordnung, ihrer Anforderungen und ihrer einheitlichen Auslegung zu wachen, hat die Europäische Kommission in die Hände des AI-Office gelegt und dieses hierzu mit zahlreichen Befugnissen, u.a. zur Überwachung von GPAI-Modellen, ausgestattet. Hierzu steht auch ein wissenschaftliches Gremium und Beratungsforum mit technischem und regulatorischem Sachverstand zur Seite und damit fachliche Expertise, um auch regulatorisch mit dem technologischen Fortschritt mithalten zu können.

Sanktionen

Für Verstöße gegen Bestimmungen der KI-Verordnung hält die KI-Verordnung u.a. ein empfindliches Sanktionen-Regime an Bußgeldern bereit, das sich – anlehnend an die bereits aus der DSGVO bekannten Regelungen – am weltweiten Jahresumsatz des vorangegangenen Geschäftsjahres oder einem pekuniären Maximalbetrag orientiert, je nachdem, welcher Betrag höher ist.

Dieser Logik folgend sieht die KI-Verordnung bei Missachtung von Vorschriften über verbotene KI-Praktiken etwa Geldbußen von bis zu 35 Millionen EUR oder bis zu 7 % des gesamten weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahrs vor.

Bei Nichteinhaltung sonstiger Anforderungen oder Verpflichtungen, einschließlich Verstößen gegen GPAI-bezogene Anforderungen, gilt ein Bußgeldrahmen von bis zu 15 Millionen Euro oder 3 % des weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahrs.

Stellen Akteure benannten Stellen oder zuständigen Behörden falsche, unvollständige oder irreführende Informationen bereit, ist mit Bußgeldern von bis zu 7,5 Millionen Euro oder 1 % des weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahrs zu rechnen.

Für kleine und mittlere Unternehmen (KMU), einschließlich Start-ups, gilt – in Abkehr vom Grundsatz, dass der jeweils höhere Betrag maßgeblich ist – der jeweils niedrigere Betrag.

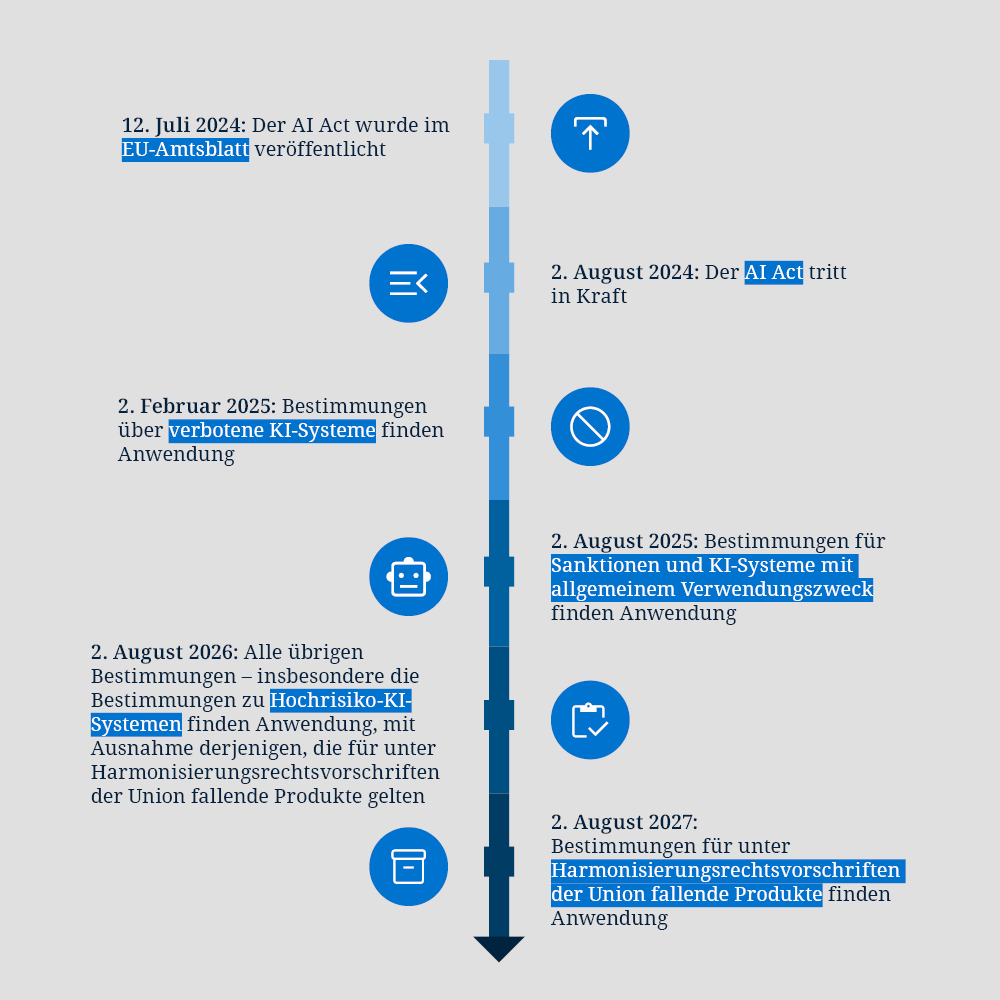

Was gilt ab wann?

Die KI-Verordnung sieht einen gestaffelten Zeitplan für den Geltungsbeginn ihrer einzelnen Regelungsabschnitte vor. So sind erste Vorschriften bereits ab 2. Februar 2025 anzuwenden, so etwa die Vorschriften zu verbotenen KI-Praktiken. Ab 2. August 2025 gelten dann sämtliche Bestimmungen über GPAI-Modelle, ab 2. August 2026 dann sämtliche übrigen Bestimmungen (insbesondere jene zu Hochrisiko-KI-Systemen). Ausgenommen sind Bestimmungen für Produkte, die KI-Systeme enthalten, jedoch bereits durch andere EU-Harmonisierungsrechtsakte geregelt sind, beispielsweise bestimmte Produkte aus dem Pharma- oder Medizinbereich. Für solche Produkte gelten die Regelungen der KI-Verordnung erst ab dem 2. August 2027.

Unmittelbarer Handlungsbedarf

Auch wenn Zeiträume zwischen sechs Monaten und zwei Jahren zunächst noch weit entfernt erscheinen mögen, bleibt Unternehmen bei genauerer Betrachtung nicht viel Zeit, sich auf die Anforderungen der KI-Verordnung einzustellen. Allein die zuverlässige und vollständige Evaluierung, wer mit welcher KI in welchem Umfang, zu welchen Zwecken und in welcher Rolle zu tun hat, ist eine interdisziplinäre Übung und verlangt eine enge Zusammenarbeit verschiedenster Akteure verschiedenster Bereiche, insbesondere aus Legal, Operative und Business, sowie über Konzerngesellschaften, Dienstleister und Jurisdiktionen hinweg.

Dieser erste Schritt ist essentiell zur Klärung, welche Anforderungen im Zusammenhang mit dem betreffenden KI-System von wem einzuhalten sind, und dürfte, abhängig von der Größe des betreffenden Unternehmens- und Konzernverbunds, mehrere Wochen, wenn nicht Monate, in Anspruch nehmen. Auf dieser Basis sind sodann geltende rechtliche Anforderungen zu definieren und Verantwortlichkeiten sowie Prozesse zu etablieren, die auf der Basis der einzelnen Anforderungen Schritt für Schritt umzusetzen wären.

Je nach Typ des jeweiligen KI-Systems kommen weitere Anforderungen wie Dokumentations-, Melde-, Transparenz- und Kennzeichnungspflichten hinzu, die ebenfalls geprüft und vorbereitet werden müssen. Wer dies berücksichtigt, erkennt, dass 6, 12 oder 24 Monate zur Umsetzung all dieser Maßnahmen nicht großzügig bemessen sind. Deshalb ist es entscheidend, umgehend mit den erforderlichen Evaluierung und Vorbereitung zu beginnen.

Wir sind vorbereitet, haben die richtigen Expertinnen und Experten, das rechtliche Know-how und die Tools. Sprechen Sie uns an!

Besuchen Sie auch unsere Fokusseite zum Thema Künstliche Intelligenz für weitere Informationen.